想象一下,你有一个巨大的仓库,里面堆满了各种货物,传统的数据库就像这个仓库,所有的货物(也就是数据)都放在货架上,而货架是建在一个移动非常缓慢的机械装置上(这就像是电脑的硬盘),每次你需要找一件特定的货物,你都得让这个慢吞吞的机械臂去货架上取,这个过程需要花费不少时间,如果同时有很多人来取货,机械臂就会忙得不可开交,整个系统的速度就被拖慢了。

而内存数据库的做法则完全不同,它相当于在仓库的门口,开辟了一个超级大、超级快的“临时分拣区”,它把那些最常用、最热门、或者需要最快处理的货物,全部从深处的货架上搬出来,整整齐齐地码放在这个分拣区里,这个分拣区是由一种速度极快的设备构成的(这就是电脑的内存,RAM),在这个区域里,你不需要等待缓慢的机械臂,工作人员(CPU)可以直接用手拿到任何一件货物,速度是瞬间完成的。

内存数据库具体是怎么做到这一点的呢?我们从“优化存储效率”和“加速数据检索”两个方面来看。

在优化存储效率上,内存数据库并不是简单地把数据从硬盘搬到内存就完事了,它做了很多深层次的精简和优化。

摆脱了磁盘格式的包袱: 传统数据库的数据在硬盘上存储时,为了应对可能发生的断电等故障,需要记录大量的冗余信息,比如日志、索引的复杂结构等,这些结构就像是为了长途运输而给货物包裹上厚厚的缓冲材料,但在内存里,数据是“活”的,是直接可以被CPU处理的,内存数据库可以设计一套更简洁、更紧凑的数据格式,专门为内存访问而优化,它去掉了那些为了磁盘持久化而设计的复杂“包装”,让数据本身更“赤裸”,更直接,这就好比在分拣区,货物都被拆去了笨重的外包装,只保留最核心的货品,并且按照最方便拿取的方式排列,这样同样大小的分拣区就能放下更多种类的核心货物。

更高效的数据压缩: 因为内存虽然快,但成本比硬盘高,容量通常也小一些,所以内存数据库会采用非常高效的数据压缩算法,由于数据是在内存中进行压缩和解压缩,这个速度非常快,几乎不带来明显的延迟,通过压缩,可以用更少的内存空间存储更多的数据,这本身就是一种存储效率的巨大提升,相当于在高速分拣区里,通过一种神奇的折叠技术,把货物体积缩小,但又不影响快速取用。

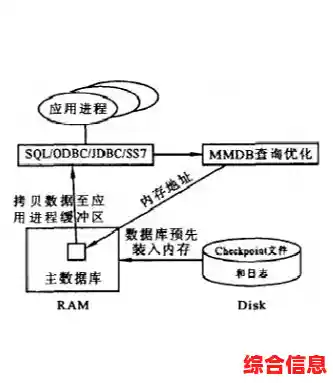

简化数据处理的中间步骤: 传统数据库在执行一个查询时,需要很多中间步骤,比如从硬盘读入数据到内存的“缓冲区”,再进行计算,这个“缓冲区”的管理本身就是一套复杂的开销,而内存数据库的数据天生就在“缓冲区”里,它省去了这个繁琐的步骤,数据处理路径更短、更直接。

在加速数据检索过程上,内存数据库的优势是颠覆性的。

硬件级的速度差异: 这是最根本的原因,内存(RAM)的访问速度是纳秒级别的,而即便是最快的固态硬盘(SSD),其访问速度也是微秒级别,两者之间存在着千倍甚至万倍的速度差距,这种硬件上的鸿沟,是任何软件算法都无法逾越的,直接从内存取数据,就像从触手可及的桌面上拿东西,而从硬盘读数据,就像要下楼去车库的储物箱里翻找。

极致的索引优化: 索引就像是仓库的货物清单,在传统数据库中,即使有索引,查找索引本身也可能需要读写硬盘,还是会慢,而在内存数据库中,所有的索引也完全常驻在内存里,这意味着查找索引的速度也是内存级的,更重要的是,因为不再担心磁盘IO是瓶颈,内存数据库可以大胆地使用更多、更复杂的索引结构,它可以为经常查询的字段创建多种类型的索引,像哈希索引(适合精确查找)、位图索引(适合多条件组合查询)等,这些索引在内存中能发挥出最大的威力,让数据查找几乎瞬间完成。

无锁数据结构和并行处理: 当很多人同时访问数据库时,传统数据库需要用“锁”来防止数据被改乱,而加锁和解锁的过程会带来等待,降低并发性能,内存数据库可以利用内存访问的特性,设计一些更高级的无锁数据结构或乐观锁机制,极大地减少了线程之间的等待和冲突,CPU可以直接在内存中并行处理大量的数据运算,比如复杂的连接(JOIN)和聚合(GROUP BY)操作,速度比在磁盘上一个个读取块要快得多。

内存数据库的优化逻辑核心在于“空间换时间”和“贴近CPU”,它利用内存这种高速但昂贵的存储介质,通过重新设计数据存储格式、采用高效压缩、简化处理流程来极致地优化存储效率;它充分发挥内存的硬件速度优势,结合更强大的内存索引和并行处理能力,将数据检索的速度提升到了传统磁盘数据库难以企及的高度,它就像是为数据处理这个任务,搭建了一条从CPU直接到数据的“高速公路”,彻底绕开了硬盘这个“城乡结合部的拥堵路段”,这种方案的成本更高,且需要解决断电后数据持久化的问题(通常通过日志和快照结合电池备份等方式),但在需要极致速度的场景下,比如金融交易、实时推荐、电信计费等领域,它的优势是不可替代的。